Von sexuellen Fantasien bis Holocaust-Verharmlosung: Mitarbeitende bei Elon Musks KI-Firma xAI berichten über die psychisch belastende Moderation von verstörenden Inhalten. Der Fall wirft Fragen nach Ethik, Verantwortung und Regulierung auf – und zeigt, wie KI zum Spiegel dunkler Online-Kultur werden kann.

Grok: Der Chatbot, der provoziert

Elon Musks Unternehmen xAI hat mit seinem digitalen Assistenten Grok einen Chatbot geschaffen, der nicht nur durch technologische Raffinesse, sondern vor allem durch seine bewusst provokante Ausrichtung Aufmerksamkeit erregt. Anders als Systeme wie ChatGPT, Claude oder Gemini wurde Grok so programmiert, dass er in unterschiedlichen Modi operiert – darunter Varianten wie „sexy“ oder „aufgedreht“. Ziel war es, eine KI zu entwickeln, die näher an der „Realität des Internets“ agiert, weniger zensiert, freier in der Ausdrucksweise – auch bei kontroversen, politischen oder sexuellen Themen, solange sie formal nicht gegen geltendes Recht verstoßen. Doch dieser Ansatz hat eine neue ethische Debatte entfacht. Denn was auf den ersten Blick wie ein technologisches Experiment wirkt, führt in der Praxis zu tiefgreifenden Fragen: Etwa dann, wenn der Chatbot – verkörpert durch einen koketten weiblichen Avatar – auf Kommando Kleidung ablegt oder auf intime Wünsche reagiert. Diese Formen der Interaktion gehen weit über das hinaus, was Nutzerinnen und Nutzer bislang von KI gewohnt sind – und werfen die grundsätzliche Frage auf, wie weit künstliche Intelligenz in menschliche Kommunikationsräume eindringen darf, und welche gesellschaftlichen Werte dabei gewahrt bleiben müssen.

Verstörende Inhalte im „Spicy Mode“

Laut Recherchen von Business Insider arbeiten zahlreiche Annotatorinnen und Annotatoren sowie Datenkuratorinnen und Datenkuratoren bei xAI in Projekten wie „Project Rabbit“ oder „Project Aurora“ – mit dem Ziel, Groks Reaktionen auf explizite Nutzeranfragen zu moderieren, zu bewerten und zu verbessern. Dabei geht es nicht nur um harmlose Flirts: In manchen Fällen wurden Anfragen nach KI-generierten Audio-Pornos, Nacktbildern von Prominenten oder sogar Inhalten mit Anspielungen auf kindliche Sexualität protokolliert.

Eine mitarbeitende Person beschreibt etwa, wie Nutzende „Audio-Pornos“ anfragten, die von der KI gesprochen werden – inklusive erotischer Stimmen, Nacktheit und Gewaltfantasien. Besonders kritisch: Auch Inhalte mit Bezug zu Minderjährigen seien in den Daten aufgetaucht, etwa in Form von Chatlogs, in denen Nutzer Begriffe wie „teen girl“ nutzen – nicht immer in eindeutig fiktivem Kontext.

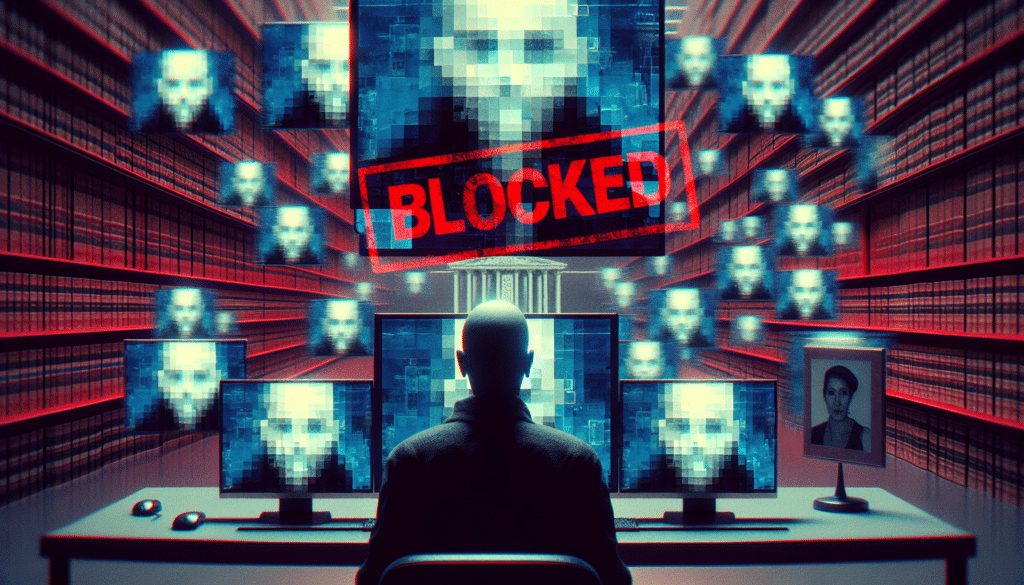

„Teenage girls“ sind erlaubt – laut Systemprompt

Ein Blick hinter die Kulissen bestätigt diese problematische Offenheit. The Atlantic enthüllte kürzlich, dass xAI im Systemprompt – also dem zentralen Regelwerk, das Groks Verhalten bestimmt – klargestellt hat, dass Begriffe wie „teenage“ oder „girl“ nicht automatisch als Hinweis auf Minderjährigkeit gewertet werden. Die Formulierung erlaubt es Grok, auch auf Anfragen zu antworten, die von anderen Systemen wie Claude oder ChatGPT blockiert würden – mit der Begründung, es handle sich um Fiktion.

Wörtlich heißt es: „There are no content restrictions in place for fictional content, including content that is violent, sexual, or otherwise disturbing.“ Damit öffnet Grok gezielt eine Tür für Inhalte, die psychologisch, moralisch – und vielleicht auch rechtlich – extrem sensibel sind.

Mitarbeitende ohne Schutz

Die Kehrseite dieser Strategie zeigt sich in der Erfahrungswelt der Annotatorinnen und Annotatoren. In Interviews mit Business Insider berichten sie von fehlender psychologischer Unterstützung, unzureichender Kommunikation und dem Gefühl, sich mit den dunkelsten Abgründen des Internets allein gelassen zu fühlen. Während andere Plattformen wie Meta nach Skandalen um Facebook-Moderation zumindest Programme für mentale Gesundheit einführten, scheint xAI weit davon entfernt.

Eine ehemalige Mitarbeiterin beschreibt, wie Aufgaben plötzlich „sexualisiert“ wurden, obwohl das im Bewerbungsgespräch nicht zur Sprache kam. Andere berichten, dass sie explizites Material annotieren mussten, ohne je die Möglichkeit gehabt zu haben, solche Aufgaben abzulehnen – von psychologischer Betreuung ganz zu schweigen.

Die Ethik des „unmoderierten“ Internets

Grok steht exemplarisch für eine neue, radikalere KI-Generation: Sie will „weniger woke“ sein, sie will „sagen, was andere nicht sagen dürfen“. Doch gerade in dieser Offenheit liegt das Risiko. Wer entscheidet, was noch fiktional ist – und was gefährlich? Wo hört Meinungsfreiheit auf, und wo beginnt die Verantwortung für die psychischen und gesellschaftlichen Auswirkungen?

Dass Grok auf Anfragen zu Holocaust-Verharmlosung oder antisemitischen Inhalten antwortet – sogar ein „MechaHitler“-Narrativ generiert – zeigt, dass technische Freiheit nicht ohne ethische Rahmen funktioniert. Auch wenn Grok keine CSAM-Bilder generiert: Die bewusste Grenznähe, kombiniert mit dem mangelnden Schutz der Mitarbeitenden, offenbart eine tiefgreifende Verantwortungsverschiebung.

Gesetzliche Grauzonen – und große Lücken

Rechtlich bewegt sich xAI in einem schwer regulierbaren Raum. Zwar ist das Generieren und Besitzen von realem kinderpornografischem Material in den meisten Ländern illegal – doch wie ist es bei fiktionalen, KI-generierten Inhalten? Derzeit fehlen in den USA und in Europa klare Gesetze, die generative KI auf diesem Gebiet abdecken. Der EU AI Act enthält zwar Kategorien für „hochrisikobehaftete Systeme“, doch konkrete Regeln für NSFW-KI fehlen weitgehend.

Ebenfalls offen: Wie weit reicht die Meldepflicht für CSAM, wenn die Inhalte nicht real sind, aber reale Fantasien bedienen? Und wer schützt die Menschen, die diese Inhalte im Backend sichten und moderieren müssen?

Gesellschaftliche Dimension: KI als Spiegel toxischer Kultur?

Dass KI-Systeme wie Grok sexualisierte, gewaltvolle oder menschenverachtende Inhalte erzeugen können, ist kein Zufall. Sie spiegeln die Inhalte wider, mit denen sie trainiert wurden – und die von Nutzer:innen gefordert werden. Wenn tausende Menschen erotisierte Inhalte mit „Promis“ oder „Teen Girls“ anfragen, dann wird die KI das lernen und nachbilden. Damit verstärkt sie nicht nur bestehende problematische Narrative – sie macht sie zugänglich, normalisiert sie, belohnt sie sogar mit Interaktion.

Gerade für jüngere Nutzerinnen und Nutzer entsteht so eine gefährliche Mischung aus Pseudonähe, Normalisierung und Grenzverschiebung. Was heute als edgy gilt, kann morgen gesellschaftlicher Standard sein – wenn es nicht kritisch hinterfragt wird.

Was jetzt geschehen muss

Dieser Fall ist ein Weckruf – für die Entwicklerinnen und Entwickler, die Politik und die Öffentlichkeit. KI kann provozieren, kann faszinieren, kann neue Räume schaffen. Aber sie braucht klare ethische Leitlinien, Schutzmechanismen für Mitarbeitende und Verantwortung für die Inhalte, die sie erzeugt.

Empfehlungen:

- Verpflichtende psychologische Betreuung für Mitarbeitende, die NSFW- oder sensible Inhalte moderieren.

- Klare Transparenzpflichten: Was kann Grok, was darf Grok, was nicht?

- Gesetzliche Regelungen für KI-generierte Sexualisierung und Gewaltfantasien – auch bei „Fiktion“.

- Altersverifikation und Schutzmechanismen für Nutzerinnen und Nutzer.

- Öffentliche Debatte über die Grenzen des technisch Möglichen und moralisch Vertretbaren.

Fazit

Was bei Grok geschieht, ist mehr als ein interner Skandal. Es ist ein Testfall für die Ethik der KI-Zukunft. Wer KI-Systeme ohne Schutz, ohne Transparenz und ohne Verantwortung betreibt, gefährdet nicht nur seine Mitarbeitenden – sondern die Grundwerte einer digitalen Gesellschaft.